Skygge-AI: IT-udfordringen ingen taler om

Uden IT-afdelingens viden bliver følsomme data hver dag indtastet i AI-værktøjer som ChatGPT. Fænomenet kaldes Skygge-AI, og det er en af de hurtigst voksende og mest oversete trusler mod datasikkerheden i dag.

Indholdsfortegnelse

IT-landskabet er ved at ændre sig, og vi ser mange enheder, der på nye måder tager kunstig intelligens i brug. Det giver helt nye muligheder for brugerne, men også en udfordring for IT-afdelingen, der nu skal håndtere systemerne. Det er netop her, Skygge-AI opstår, når ansatte selv finder og anvender AI-værktøjer uden for skolens systemer og uden klare rammer. I denne artikel ser jeg på det nye IT-landskab med udgangspunkt i en undervisningsinstitution og skitserer en mulig retning, som IT-afdelinger kan arbejde videre med.

Skygge-AI er de AI-værktøjer, som medarbejdere bruger uden IT-afdelingens viden eller godkendelse, og som der derfor ikke er kontrol over. Den enkelte medarbejder har som regel gode intentioner, når vedkommende bruger værktøjerne.

Det særlige i forhold til begrebet Shadow IT er, at der ikke kun er tale om software, men om systemer, der i højere grad bearbejder organisationens data uden gennemsigtighed, hvilket kan få meget store konsekvenser.

Skygge-AI: Bring your own AI!

Den største udfordring, som jeg ser lige nu, er en videreudvikling af “Bring your own device”-problematikken, hvor medarbejderne selv medbringer deres egne enheder. Nu kan vi kalde det “Bring your own AI”. Vi ser rigtig mange ansatte, der finder og bruger en række, ofte usikre, AI-værktøjer uden klare databehandlingsaftaler. Det kan være alt fra den kinesiske sprogmodel DeepSeek til dybt integrerede AI-værktøjer på deres egne computere.

En stor udfordring er, at skolens politikker ikke længere er tilstrækkelige, og at ansvaret for datasikkerhed ender hos den enkelte medarbejder, som sjældent har forudsætningerne for at vurdere risikoen. Det kan handle om alt fra brud på GDPR til krænkelse af ophavsret. For eksempel når en lærer uploader en hel lærebog til en AI-tjeneste for at få genereret elevspørgsmål, eller når en administrativ medarbejder anvender ChatGPT til at renskrive fortrolige referater fra ledelsesmøder med følsomme personalesager. Disse handlinger sker ofte i bedste mening, men konsekvenserne kan være alvorlige, både juridisk og for institutionens troværdighed.

Problemet bliver endnu større, når den enkelte medarbejder har sin egen computer, hvor de selv har valgt programmerne. Her er det meget flygtigt, hvad der er installeret, og IT-afdelingen har ikke et overblik.

Samtidig skal vi være opmærksomme på, hvad eleverne gør i undervisningen. De virker mere eksperimenterende og ukritiske i forhold til, hvilke tjenester de tilmelder sig, og de har heller ikke altid styr på, hvad der er personfølsomme data.

Det kan være svært at følge med, for alt ser ud til at blive beriget med AI på den ene eller anden måde, men vi må være proaktive og finde en ny vej frem.

Klare rammer for AI i strategien

De gamle IT-politikker er ikke bygget til den nye virkelighed, og derfor er uddannelsesinstitutioner og IT-fællesskaber nødt til at etablere en klar ramme for AI. Modsat IT-politikker influerer AI på langt mere, end vi tidligere har været vant til, og derfor er man nødt til at nedsætte en gruppe med repræsentanter fra ledelsen, HR, jurister og dem, der skal arbejde med det i hverdagen. Læg mærke til, at jeg ikke mener, det er en ren IT-opgave, og det er ikke bare en opgave, der skal parkeres i hjørnet af organisationen.

Gruppen skal sammen definere, hvad uddannelsesinstitutionen vil med AI, og måske endnu vigtigere, hvilke data der under ingen omstændigheder må indtastes i offentlige sprogmodeller.

Her mener jeg, at første skridt er at etablere fire grundlæggende byggesten:

- Godkendte AI-værktøjer: En klar liste over, hvilke værktøjer institutionen stiller til rådighed og understøtter

- Dataklassificering: En enkel opdeling i offentlige, interne og fortrolige data

- No-go-zoner: Et absolut forbud mod at behandle specifikke datatyper i offentlige AI-systemer

- Forbudte værktøjer: En liste over AI-tjenester medarbejdere ikke må anvende (fx DeepSeek)

Dette skal naturligvis ske inden for rammerne af GDPR, men institutionen kan også have yderligere data, der kræver beskyttelse.

Udfordringen er, at udviklingen sker meget hurtigt. Apple Intelligence rulles ud på Mac-enheder, Windows integrerer AI direkte i styresystemet, og grænserne for, hvornår AI bruges, bliver stadig mere uklare. Må en AI læse korrektur på en email, inden den sendes i Outlook? Sådanne spørgsmål kræver klare svar, inden de opstår i hverdagen.

Det sikre og godkendte alternativ

Som skole kan vi godt blokere forskellige værktøjer, men udfordringen er, at brugerne blot finder alternativer. Derfor er den eneste holdbare løsning at tilbyde et sikkert og godkendt alternativ, som samtidig er velfungerende. Der er dog et kapløb mellem de private virksomheder og det, en skole har mulighed for at stille til rådighed. Edu-licenser er ofte mere restriktive, og nogle sprogmodeller, der i dag tilbydes til skoler, er andenrangs AI-systemer.

Ved at investere i en enterprise-løsning, hvor vores data forbliver vores egne, som fx Microsoft Copilot eller Google Gemini for Workspace, kan vi give medarbejderne de værktøjer, de efterspørger, men i et kontrolleret og sikkert miljø. Når den godkendte løsning er let tilgængelig og velfungerende, forsvinder behovet for at søge usikre alternativer.

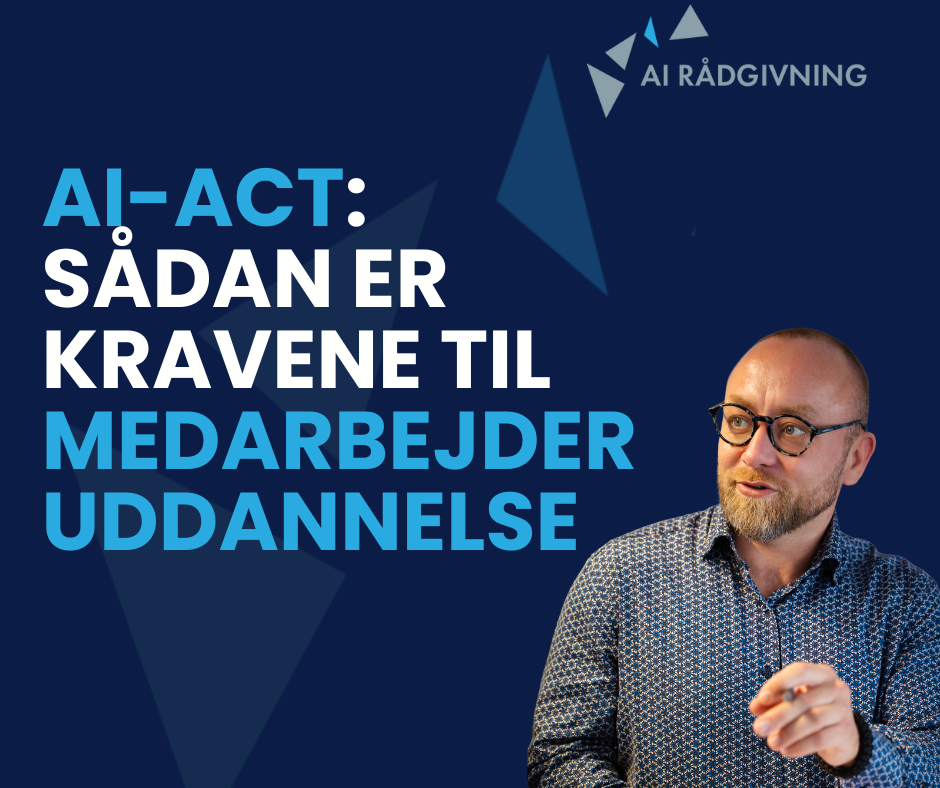

Uddannelse af medarbejderne er det stærkeste værn

Det bedste forsvar mod datalæk og fejl omkring AI og IT er, at medarbejderne er uddannet og velinformerede i den nye teknologi. AI-forordningen stiller en række krav til, hvad den enkelte medarbejder skal kunne, hvis de interagerer med eller underviser om og med AI. Her har jeg samlet de vigtigste punkter:

- Lærerne skal have en solid forståelse for, hvordan AI fungerer, og hvilke muligheder og begrænsninger der er ved teknologien.

- De etiske overvejelser og potentielle risici ved anvendelsen af AI, herunder risikoen for bias, diskrimination og krænkelse af privatlivets fred.

- De juridiske rammer for brug af AI, herunder AI-forordningens regler og krav.

- Hvordan man kan undervise eleverne i at bruge AI på en ansvarlig og hensigtsmæssig måde.

Det betyder også, at der skal investeres i uddannelse af medarbejderne i rammerne for AI, og at de forstår, hvorfor vi har disse regler.

Afslutning

Ovenstående udfordringer med Skygge-AI forsvinder ikke af sig selv, og det er ikke muligt at forbyde dem, da der hele tiden kommer nye systemer. Derfor er den eneste vej frem en tredelt indsats, hvor vi fastlægger klare rammer i en samlet strategi, tilbyder attraktive og sikre værktøjer og, vigtigst af alt, investerer i at uddanne vores medarbejdere.

Samtidig mener jeg, at det er en opgave for hele organisationen at arbejde med AI, for alle medarbejdere vil på en eller anden måde berøre det i dagligdagen. Dermed kan AI blive en reel pædagogisk mulighed for både uddannelsesinstitutionen og den enkelte medarbejder i stedet for en udfordring, som medarbejderen står alene med.

Kun ved at gøre alt dette kan undervisningsinstitution gå fra at slukke ildebrande til at bygge en sikker vej frem, hvor kunstig intelligens bliver en reel pædagogisk gevinst frem for en ukontrolleret risiko.

Kilder