Huxley-Gödel-maskinen: Når AI lærer at lære og udfordrer undervisningen

Forskere fra KAUST har præsenteret en ny type AI, som kan omskrive og forbedre sin egen kode. Den kaldes Huxley-Gödel-maskinen og markerer et afgørende skridt mod en form for intelligens, som ikke blot lærer, men lærer at lære.

Indholdsfortegnelse

Denne artikel tager udgangspunkt i en forskningsartikel fra KAUST, som i sidste uge offentliggjorde en interessant udgivelse om visionen for en ny type Gödel-maskine. Det bliver måske en smule fremtidsorienteret, men udgivelsen fra KAUST var en af dem, jeg personligt har ventet på.

Grundlæggende er det nye:

AI som retter sin egen kode for at blive en bedre AI.

Ok, læs lige det igen, og vent med at blive alt for skræmt.

Jeg gengiver de vigtigste pointer fra artiklen og forklarer baggrunden. Det er den mere tekniske del, som jeg efterfølgende sætter ind i en undervisningskontekst. Det hele har måske et strejf af filosofi, men der er god grund til at tage denne nye mulighed alvorligt. Om ikke andet, så blot for at vide, hvor udviklingen inden for AI bevæger sig hen.

Hvis du er politiker, uddannelsesforsker eller blot nysgerrig på lovgivningen omkring AI, giver denne artikel helt sikkert stof til eftertanke.

Inden vi kommer så langt, skal vi se nærmere på, hvad Gödel-maskinen egentlig er. Hvis du synes, at AI allerede er imponerende, vil næste generation formentlig overraske dig, for den er langt mere end en ny version af ChatGPT.

Gödel maskinen

Gödel-maskinen skal forstås som en teoretisk idé, der ofte tilskrives AI-forskeren Jürgen Schmidhuber. Konceptet er grundlæggende en selvforbedrende AI, som kan analysere og omskrive sin egen kildekode for at optimere sig selv. Den oprindelige idé, som både er genial og umulig, var, at maskinen kun måtte ændre sig selv, hvis den formelt kunne bevise, at ændringen ville forbedre den på lang sigt.

Det lyder måske simpelt, men man kan ikke bevise effekten af en ændring, før den er blevet afprøvet. Dette betyder at hver gang koden køres, bliver den teknisk set en bedre eller dårligere version af sig selv.

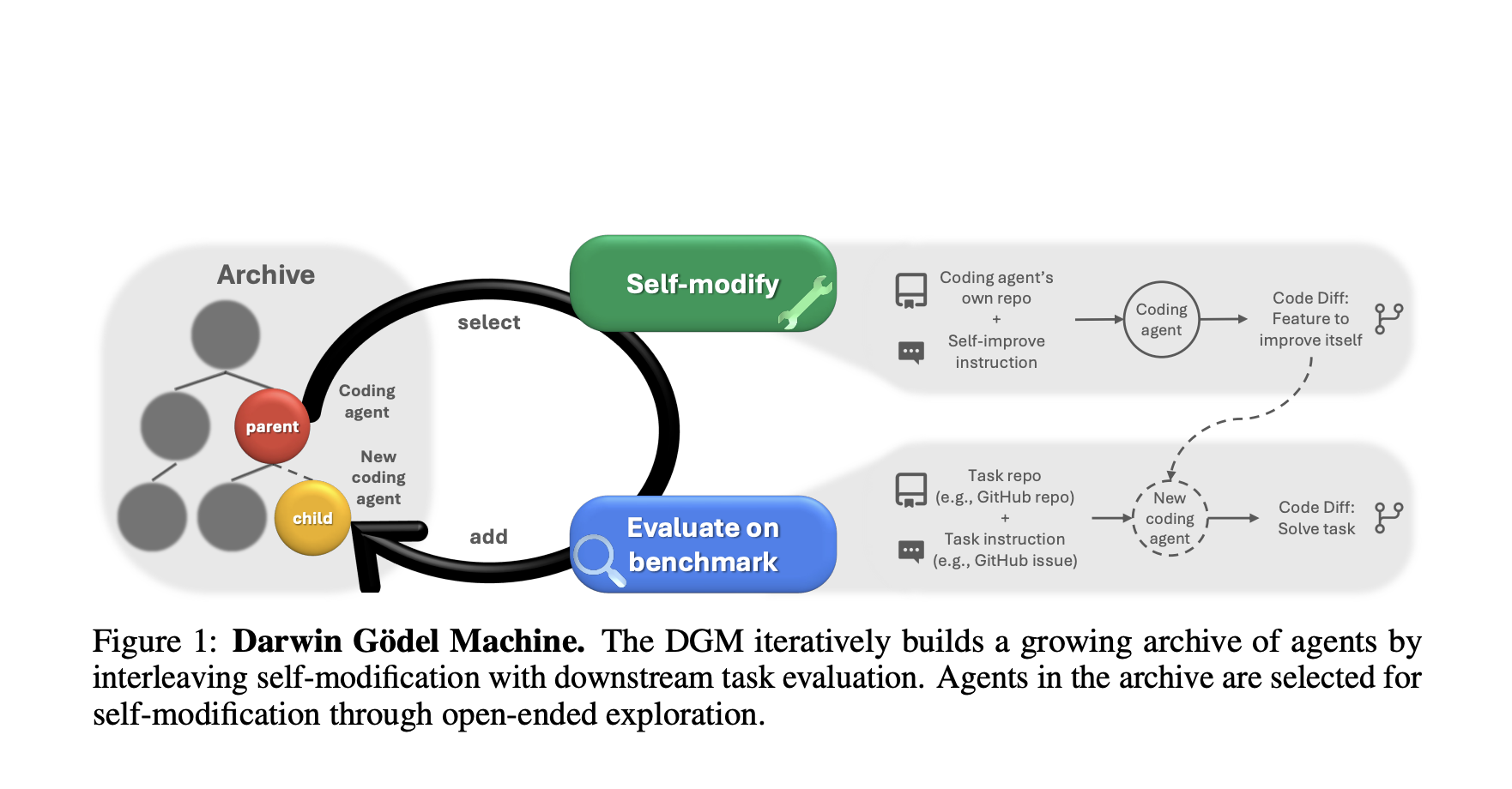

Nyere idéer løsner op for det umulige krav om bevis og udforsker flere forskellige retninger. Et eksempel er Darwin-Gödel-maskinen (DGM), som fjerner kravet om formelt bevis og i stedet introducerer empirisk validering. Her lader man AI’en skabe en ny version af sig selv og tester derefter, hvilken der klarer sig bedst i en række opgaver. Alle versioner gemmes i et arkiv, som bruges til at sikre, at modellen ikke sidder fast i en uhensigtsmæssig evolutionær udvikling.

Det er et interessant koncept, som bygger på idéen om, at den stærkeste overlever. Udfordringen er dog, at den kun vurderer, om agenten præsterer godt her og nu.

Hvor Darwin-Gödel-maskinen primært fokuserer på den enkelte agents præstation, har Huxley-Gödel-maskinen (HGM) fra KAUST en langt mere vild tilgang.

Huxley-Gödel maskinen (HGM)

Huxley-Gödel-maskine bygger på idéen om, at en AI-agent godt kan klare en test perfekt her og nu, men alligevel være dårlig til at skabe intelligente efterkommere. Dette kalder de et misforhold mellem metaproduktivitet og præstation.

Problemet med det umulige bevis i Gödel-maskinen forsøger de at løse ved at indføre en ny måleenhed, kaldet Clade Metaproductivity (CMP). CMP måler det langsigtede potentiale, og derfor er maskinen ikke optaget af, hvordan den enkelte agent klarer sig her og nu. I stedet vurderes den samlede succes for hele slægten.

Derfor favoriseres de stamfædre, hvis slægt over tid har været bedst til at forbedre sig. Grundlæggende svarer det til, at en lærer ikke vurderer, hvor godt eleverne klarer sig i dag, men snarere, hvor gode de bliver til selv at lære videre. Systemet satser dermed på den elev, der lærer at lære, frem for den elev, der bare terper til testen.

Man kunne sige, at hvis Darwin-Gödel-maskinen handler om “survival of the fittest”, så handler Huxley-Gödel-maskinen om “survival of the fittest family”.

Huxley-Gödel-maskinens muligheder og påvirkning af undervisningen

De AI-systemer, vi ser i undervisningen i dag, er statiske, trækker på data fra store sprogmodeller og følger en forholdsvis fast struktur. I de store sprogmodeller har vi naturligvis ikke fuld kontrol over outputtet, men det er nogenlunde ens ved samme forespørgsel. Imens ser vi at nogle af de nyere systemer er begyndt at tilføje hukommelse og kan dermed bruge tidligere interaktioner til at skabe mere personlige svar.

Det er denne type systemer, vi har i dag, men fremtidens AI-systemer vil rumme en helt ny type intelligens, der rekursivt kan forbedre sin egen evne til at lære.

Man kan også formulere det:

ChatGPT/Claude = En færdiguddannet ekspert, der bruger det, den har lært.

Huxley-Gödel-maskinen = En ekspert, der konstant omskriver sin egen hjerne for at blive bedre.

Med disse tanker vil jeg nu forsøge at spå om mulighederne med Huxley-Gödel-maskinen i undervisningen.

Tanker om den ultimative AI-partner

Dette afsnit udforsker Huxley-Gödel-maskinen som den ultimative AI-partner, hvilket er én mulig udviklingsvej blandt flere, der ikke nødvendigvis bliver realiseret på grund af etiske og moralske hensyn.

I artiklen om Huxley-Gödel-maskinen gives AI’en en uddannelsesplan, der består af et statisk sæt kodningsopgaver. Dens opgave er at finde den “fittest family”, der kan løse disse opgave.

Men overvej, hvad der sker, hvis vi udskifter dette mål og i stedet beder AI’en maksimere den pågældende elevs kontekstforståelse. Hermed får eleven ikke blot endnu en adaptiv læringsapp, men en AI-partner, der kontinuerligt gennemfører en HGM-evolution på sig selv for at blive den bedst mulige AI-tutor.

Det er måske lidt abstrakt, men man kunne fx forestille sig, at en elev sidder fast i en brøkopgave, og her vil en almindelig AI blot give en nemmere opgave. En HGM-agent ville internt køre tusindvis af simulationer og finde den næste, perfekte pædagogiske øvelse. Den prøver herefter, ved hjælp af CMP, at identificere netop den slægt af undervisningsstrategier, som har den højeste teoretiske sandsynlighed for at skabe en aha-oplevelse hos netop denne elev.

AI'en begynder altså at opfinde en ny form for pædagogik der er 100% skræddersyet til den enkelte elev.

Som jeg skrev tidligere er denne tanke måske lidt vild, men man kunne også forestille sig en lidt mere sikker brug af HGM-agenter.

Huxley-Gödel-maskinen som fortolker af learning analytics

Da jeg i sin tid skrev speciale, udviklede jeg et learning dashboard og præsenterede læreren for elevens flow-tilstand. Det var grundlæggende ret brugbart til at understøtte læreren i deres observationer, men et af mine fund var, at det var svært at fortolke alle disse data, og samtidig meget tidskrævende.

Overvej hvad der sker, hvis Huxley-Gödel-maskinen i stedet fungerer som en analytiker, der understøtter læreren. Her får AI’en adgang til anonymiserede data fra 8. klassernes arbejde med brøker. Læreren giver herefter AI’en en prompt om, at eleverne har svært ved at forstå brøker.

I ovenstående tilfælde vil HGM lede efter skjulte mønstre i de anonymiserede data og køre sin evolutionære analyse. Hvis det var en almindelig maskinlæringsmodel som den, jeg brugte i mit speciale, ville den udelukkende pege på det åbenlyse. Det ville for eksempel være, at den elev, der øver sig mest, også klarer sig bedst.

Men en HGM vil gå dybere og igangsætte tusindvis af nye analyseagenter for at finde det mest produktive mønster. Herefter vil den favorisere den slægt, der er bedst til at finde de skjulte sammenhænge. I det nævnte tilfælde kunne det vise sig, at alle de elever, der fejler, har misforstået et specifikt ord i opgaveteksten.

Resultatet er, at den er med til at fjerne de fortolkningsudfordringer, jeg selv identificerede i mit speciale. AI kan derfor bruges til at fortolke data og levere indsigt, som mennesker let ville overse.

Faren ved Huxley-Gödel-maskinen i undervisningen

I ovenstående har jeg udlagt to forskellige visioner for brugen af HGM, og hvor den første tanke går ret langt og udlicetierer hele pædagogikken til en maskine, så virker en datafortolker som noget vi godt kunne set det fornuftige i allerede i dag.

Men, noget som forskerene påpeger i artiklen er, at når de kikkede på den kode som AI'en havde skrevet for at forbedre sig selv, så var den "mind-bending". AI'en havde opfundet sin helt egen, højeffektive måde at strukturerer logikken på, som var ulæselig af forskerne. Dermed havde forskerne skabt en "sort boks", hvor selv forskerne ikke kunne forstå koden.

I sig selv er det et etisk problem at der ikke er transparens i logikken og systemet, især hvis det skal bruges i undervisningen.

Og endnu mere foruroligende er det når AI-agents pædagogiske metode ikke giver mening for læreren. Måske finder den ud af, at den bedste måde for en 8. klasse der skal lære om brøker er, at starte med algebra.

Tør vi overhovedet stole på en sort boks vi ikke forstår?

Den største fare ved Huxley-Gödel-maskinen

De, der har læst med hertil, vil nok kunne regne ud, at der er nogle lidt større udfordringer med maskinen end dem, jeg har beskrevet ovenfor.

I artiklen nævnes det selv, at det er en blind avlsmaskine, som er ligeglad med, hvad den optimerer, så længe den maksimerer sit mål. Det leder os til to helt afgørende risici ved teknologien.

Elever er heller ikke altid rationelle – og heldigvis for det. Men hvad sker der, når en elev keder sig, begynder at tegne mønstre på papiret eller blot sidder og kigger ud ad vinduet? En AI, der er optimeret til at maksimere læringshastigheden, vil se dette som fejl, der skal rettes. Den vil derfor fremavle den mest effektive strategi for at få eleven tilbage på sporet.

Elevens frie vilje, som inkluderer kedsomhed og kreative pauser, opfattes ikke som effektiv af maskinen, og derfor skal de optimeres væk.

Afslutning

Brugen af Huxley-Gödel-maskinen i undervisningen ligger formentlig nogle år ude i fremtiden, men vi skal allerede nu sikre, at den ikke tager over og eksperimenterer med kommende generationer.

Det kan måske lyde som om, at det ovenstående blot er filosofiske tanker, eller som om en forsker sidder i et lille lukket system og arbejder med HGM. Hele kildekoden til maskinen er imidlertid frit tilgængelig på GitHub, hvilket gør det muligt selv at afvikle og tilpasse systemet. Det er derfor heller ikke science fiction, men noget der allerede eksisterer.

At inddrage selvforbedrende AI i undervisningen kan ske på mange måder, men vi må sikre, at det sker på den rigtige måde og uden at vi mister kontrollen. Jeg mener ikke, at vi skal overlade det til techvirksomhederne at fastsætte disse retningslinjer. Det bør i stedet sikres politisk.

Kilder

Hovedkilde til denne artikel: